AI verovert het lab, maar hoe betrouwbaar is ChatGPT als digitale collega? Met de opkomst van AI-tools zoals ChatGPT en LabGPT staan laboratoria aan de vooravond van een technologische revolutie. Steeds meer lab professionals experimenteren ermee, vooral bij rapportage, data uitleg en literatuuranalyse.

Ook binnen de Morgan Lab-community (met momenteel meer dan 7.000 laboratorium professionals) signaleren we een groeiende nieuwsgierigheid naar AI in het lab. Uit onze eigen peiling onder laboratoriummedewerkers blijkt dat ChatGPT inmiddels een rol speelt in het dagelijks werk, al is dat vaak nog voorzichtig en afgebakend. De toepassing varieert van het structureren van rapportages tot het verhelderen van vakjargon of het checken van protocolteksten.

Tegelijkertijd leeft er twijfel: hoe betrouwbaar is AI in een vakgebied waar precisie en validatie essentieel zijn? Hoe ga je verantwoord om met privacygevoelige labdata? En kan AI SOP’s en collega’s echt vervangen of is het juist een slimme aanvulling?

In dit blog beantwoorden we deze vragen aan de hand van praktijkervaringen, interviews met laboratorium professionals, internationale inzichten (zoals uit Reddit’s r/labrats) en onze eigen community poll. Je ontdekt wat AI op dit moment écht kan in het lab, wat (nog) niet werkt, en hoe jij als lab professional of leidinggevende hierin stappen kunt zetten: zonder risico voor kwaliteit of compliance.

Waarom AI in het lab actueler is dan ooit

De inzet van AI in laboratoria staat volop in de belangstelling, zeker nu steeds meer labprofessionals experimenteren met tools zoals ChatGPT. Onze eigen peiling onder volgers van Morgan Lab bevestigt dat: AI vindt zijn weg naar het lab, maar roept ook veel vragen op.

In een tijd waarin snelheid, efficiëntie én nauwkeurigheid cruciaal zijn, lijkt het logisch om ChatGPT te raadplegen bij het structureren van een rapport, het samenvatten van een wetenschappelijk artikel of het checken van een norm. Zeker in stressvolle situaties of bij tijdsdruk kan een AI-suggestie een welkom hulpmiddel zijn.

Daarbij komt: AI-tools zoals ChatGPT worden steeds toegankelijker. Je hebt geen technische achtergrond nodig om ermee aan de slag te gaan. Gewoon een vraag stellen en je krijgt in seconden een compleet antwoord. Dat gemak is verleidelijk.

Tegelijkertijd is de context complex. In het lab draait alles om betrouwbaarheid, protocollen, teamwork en SOP’s. De foutmarge moet vrijwel nul zijn. En dus rijst de vraag: wanneer is ChatGPT een nuttige assistent en wanneer een risico?

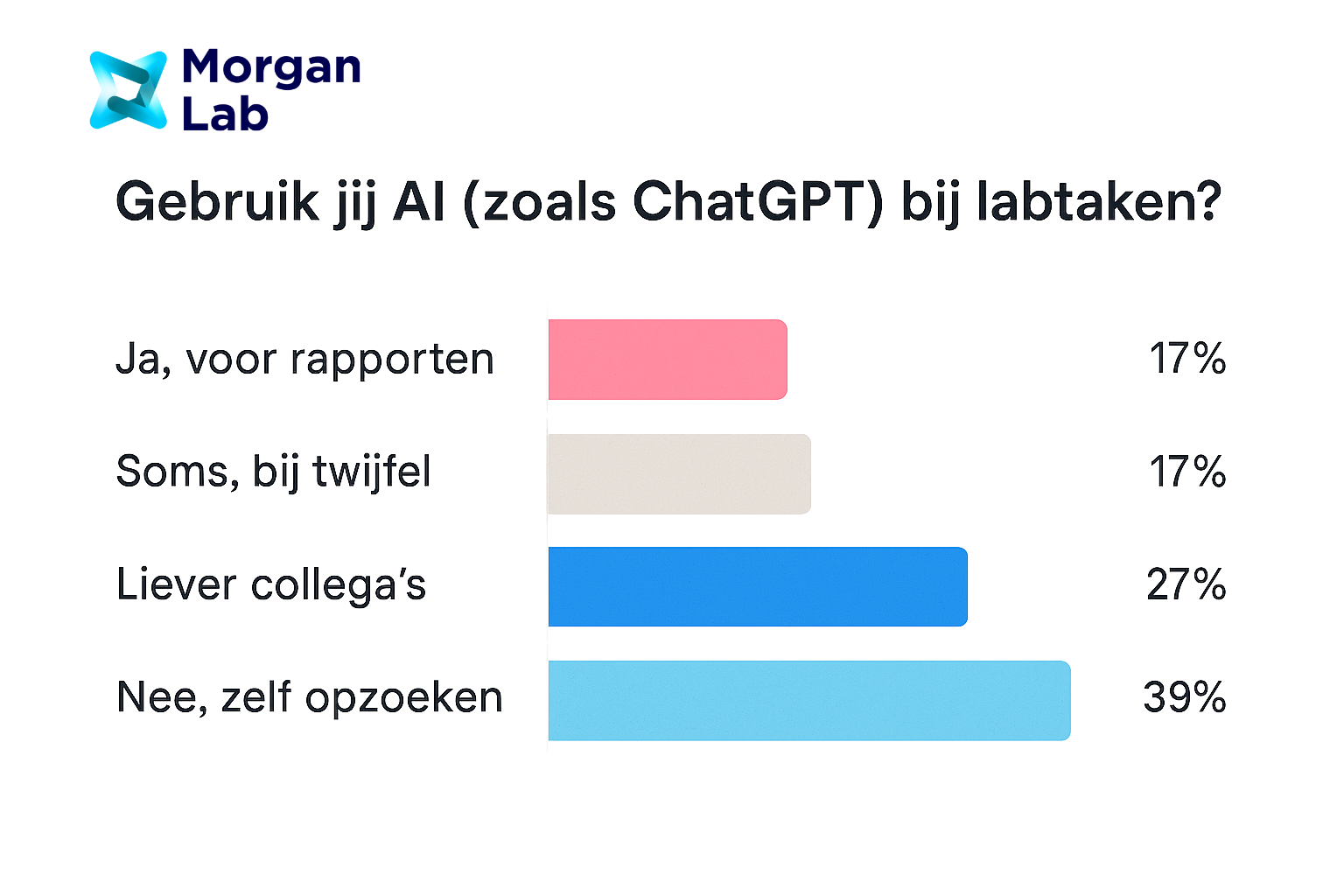

De discussie leeft sterk, ook onder labprofessionals zelf. Dat blijkt onder meer uit onze LinkedIn-poll waarin we vroegen: Gebruik jij AI (zoals ChatGPT) bij labtaken?

De resultaten:

- 17% gebruikt het voor rapporten

- 17% gebruikt het bij twijfel

- 27% overlegt liever met collega’s

- 39% zoekt liever zelf informatie op

Opvallend: AI-gebruik is dus aanwezig, maar voorzichtig. Dat geeft precies aan waar het spanningsveld ligt, tussen innovatie en verantwoordelijkheid.

In dit blog gaan we dieper in op wat AI vandaag de dag kan (en niet kan) in het lab. Wat zeggen experts, gebruikers en online communities zoals Reddit? Hoe verhoudt AI zich tot privacy, SOP’s en de menselijke interpretatie van data? En: hoe gebruik je ChatGPT verantwoord?

(bron: LinkedIn-poll Morgan Lab)

Kan ChatGPT laboratoriumresultaten lezen?

ChatGPT kan laboratoriumresultaten lezen, maar niet medisch interpreteren. De tool begrijpt structuur, context en terminologie, maar heeft geen medische kennis of klinisch beoordelingsvermogen.

ChatGPT is getraind op enorme hoeveelheden tekst, waaronder ook medische en wetenschappelijke data. Daardoor herkent het de betekenis van veelgebruikte labtermen zoals “CRP-waarde”, “Hb”, of “pH-bereik”. Het kan beschrijven wat een verhoogde waarde betekent volgens algemene richtlijnen.

Maar: ChatGPT weet niets van de specifieke patiënt, situatie of context. Het geeft dus geen diagnose en weet niet of een waarde afwijkend is voor die ene persoon. Zelfs als het antwoord ‘klopt’, is het géén vervanging van een medisch oordeel.

Bovendien is ChatGPT niet live verbonden met medische databases of richtlijnen, tenzij je het voedt met specifieke informatie. Bij het kopiëren van labwaarden moet je dus ook duidelijk zijn over de meeteenheden, referentiewaarden en bron. AI is gevoelig voor vaagheid en kan “hallucineren”: verzinsels produceren die overtuigend klinken maar feitelijk onjuist zijn.

Er bestaan inmiddels wel gespecialiseerde AI-tools zoals LabGPT, die zich toespitsen op laboratoriumresultaten. Deze tools gebruiken medische AI-modellen en hebben ingebouwde veiligheidsmaatregelen. Toch geldt ook daar: geen tool mag een gecertificeerd laborant of arts vervangen.

In praktijksituaties wordt ChatGPT soms ingezet om een eerste uitleg te geven aan een leek of om een rapport begrijpelijker te maken voor een patiënt. Dit blijkt ook uit dit artikel op ICT&Health, waarin beschreven wordt hoe AI labuitslagen omzet in toegankelijke taal voor patiënten, mits goed gecontroleerd.

Kortom: ChatGPT kan ondersteunen bij het begrijpen van laboratoriumresultaten, maar alleen als hulpmiddel, nooit als autoriteit.

Kan ChatGPT een laboratoriumrapport schrijven?

Ja, ChatGPT kan helpen bij het schrijven van een laboratoriumrapport, vooral qua structuur, stijl en samenvatting. Maar de wetenschappelijke inhoud moet altijd door een professional worden gevalideerd.

Veel laboranten gebruiken ChatGPT als schrijfassistent, blijkt uit onze LinkedIn-poll én feedback van Redditgebruikers in r/labrats. Wat het goed doet:

- Structuur aanbrengen in een verslag (inleiding, methode, resultaten, conclusie)

- Grammaticaal nakijken of herschrijven

- Samenvattingen maken van artikelen of meetdata

- Suggesties geven voor formuleringen

Kan AI laboratoriumresultaten lezen?

AI kan laboratoriumresultaten herkennen en uitleggen, maar moet altijd gecontroleerd worden door een mens. Tools als ChatGPT of LabGPT zijn geen medische experts – en dat brengt risico’s met zich mee.

Steeds meer AI-modellen worden ontwikkeld met het doel om medische of wetenschappelijke data beter toegankelijk te maken. Een goed voorbeeld is het platform LabGPT (via OpenAI GPTs), dat in staat is om basale labwaarden te verklaren, referentie-intervallen te herkennen en in begrijpelijke taal uit te leggen wat een afwijking zou kunnen betekenen. ICT&Health beschreef recent een soortgelijke toepassing waarbij AI wordt ingezet om labresultaten om te zetten naar patiëntvriendelijke taal.

Toch blijft dit terrein gevoelig. AI leest weliswaar waarden, maar begrijpt ze niet in medische of biologische context. Zonder informatie over leeftijd, geslacht, klachten of medicatiegebruik is een AI-interpretatie niet meer dan een algemene duiding.

Daarnaast speelt dat de AI geen toegang heeft tot medische richtlijnen (tenzij die expliciet ingevoerd worden) en geen klinische beslissingen kan of mag nemen. Zoals ook op Reddit in r/labrats wordt besproken: “It’s fast, but I wouldn’t trust it with diagnostics.”

AI-tools kunnen daarentegen wél uitstekend worden ingezet om routinematige taken te ondersteunen:

- Controle of alle waardes aanwezig zijn

- Opsporen van tikfouten of onlogische afwijkingen

- Uitleg geven bij standaardterminologie

In onderzoeksomgevingen kan AI ook helpen bij het structureren van grote datasets of het detecteren van trends in tijdreeksen. Toch blijft: de interpretatie hoort bij de professional.

Concluderend: AI is een waardevolle assistent bij het lezen van labdata, maar moet altijd onder supervisie van een gecertificeerde laborant of arts worden gebruikt.

Met de juiste prompt kun je ChatGPT ook specifieke stijlregels meegeven. Denk aan: “Schrijf een methodesectie voor een rapport over een titratie-experiment, in academische stijl.” De AI zal dan een neutrale, informatieve tekst genereren.

Let wel: ChatGPT weet niet wat je écht hebt gedaan in het lab. Het baseert zich op gemiddelden en schattingen. Zonder goede input krijg je onbruikbare output – of erger: foutieve aannames. Daarom is het essentieel dat je zélf controleert en redigeert.

In professionele omgevingen gebruiken veel labs ChatGPT vooral als ‘voorzet’, waarna een expert de tekst finetunet. Ook SOP’s en protocollen blijven de basis. AI is een assistent, geen vervanger.

Onze tip: gebruik ChatGPT slim bij rapportage, maar verifieer altijd de inhoud. Zie het als een digitale collega die snel typt, maar jij bent nog steeds de eindverantwoordelijke.

Hoe betrouwbaar is ChatGPT vergeleken met SOP’s en collega’s?

ChatGPT is snel en handig, maar het mist de betrouwbaarheid en controlemechanismen van SOP’s en ervaren collega’s. Gebruik het als aanvulling, niet als vervanging.

In laboratoria is betrouwbaarheid alles. SOP’s (Standard Operating Procedures) zijn daar de ruggengraat van: ze waarborgen consistentie, veiligheid en reproduceerbaarheid. Waar ChatGPT flexibel is, zijn SOP’s rigide en dat is precies de bedoeling.

Onze eigen LinkedIn-poll onder laboratoriumprofessionals laat zien dat 39% liever zélf informatie opzoekt dan AI te gebruiken. 27% vertrouwt liever op collega’s. Slechts 17% gebruikt ChatGPT direct voor rapporten.

Waarom? Omdat AI soms dingen verzint (“hallucinaties”), of antwoorden geeft zonder de context van jouw laboratorium of apparatuur. Het kent geen versienummers, weet niets van validatieschema’s en past zich niet automatisch aan jouw interne normen aan.

Collega’s daarentegen hebben context, ervaring en kunnen nuance aanbrengen. Ze weten waarom iets op een bepaalde manier moet of juist niet. Daarom zijn ze (nog) betrouwbaarder dan generatieve AI.

Toch is het goed te beseffen dat ChatGPT op een ander vlak wél uitblinkt: het biedt snelheid, helpt bij schrijven en geeft frisse invalshoeken. Als je weet wat je doet (en de output valideert) kan het je werk versnellen.

Kortom: gebruik ChatGPT als aanvulling op SOP’s en collegiale checks, nooit als vervanging. En als het om interpretaties of risicovolle taken gaat: vraag altijd een tweede paar ogen.

Waarom lab professionals ChatGPT soms wél gebruiken

Lab professionals gebruiken ChatGPT vooral om tijd te besparen, inspiratie op te doen of overzicht te krijgen. Vooral bij rapportages en het verwerken van informatie is de tool populair.

Onze pollresultaten laten zien dat bijna 1 op de 5 laboranten AI actief inzet voor rapportages. Nog eens 17% raadpleegt ChatGPT bij twijfel. De reden? Efficiëntie.

Wat je vaak hoort:

- “Even een structuur laten maken voor mijn rapport”

- “Checken of ik niks vergeet in mijn analyse”

- “Een moeilijke tekst in gewoon Nederlands laten uitleggen”

Vooral jonge laboranten of stagiairs gebruiken ChatGPT als ‘digitale kladblok’: het helpt bij de opbouw van documenten, herformuleringen of om onduidelijke termen snel opgehelderd te krijgen. Ook wordt het gebruikt als sparringpartner om SOP’s sneller te begrijpen.

Uit een Reddit-discussie blijkt dat ook internationale labprofessionals ChatGPT gebruiken voor brainstormsessies of als alternatief voor Google: “It’s like having a really fast second brain that never gets tired.”

Toch geeft bijna de helft van de deelnemers in onze poll aan dat ze liever zelf blijven zoeken, of collega’s raadplegen. En dat is begrijpelijk. AI mag dan slim zijn, maar het kent jouw apparatuur, teamafspraken of actuele interne procedures niet.

Daarom is transparantie cruciaal. Als je ChatGPT gebruikt voor labwerk, communiceer dat dan helder binnen je team. En check altijd of je output klopt met je SOP, richtlijnen en de geldende normen.

Conclusie: ChatGPT wordt wél gebruikt, maar met gezond verstand. En dat is precies hoe het zou moeten.

Wat zijn de beperkingen van AI in het lab?

AI kent geen context, geen verantwoordelijkheidsgevoel, en geen protocollen. Dat maakt het ongeschikt voor complexe, risicovolle labtaken.

Hoewel tools als ChatGPT indrukwekkende taalmodellen zijn, zijn ze niet ontworpen voor klinische of wetenschappelijke besluitvorming. De belangrijkste beperkingen zijn:

- Gebrek aan context: ChatGPT begrijpt geen situatie. Het weet niets over wie je bent, welke apparatuur je gebruikt, of welke richtlijnen in jouw lab gelden.

- Geen toegang tot actuele SOP’s of ISO-normen: AI geeft antwoorden op basis van algemene data tot het moment van training. Zonder expliciete input kent het jouw procedures niet.

- Hallucinaties: AI maakt soms fouten die klinken als waarheid. Een onjuiste uitleg van een meetmethode of foutieve normwaarden kunnen ernstige gevolgen hebben.

- Geen verantwoordelijkheid: ChatGPT draagt geen risico. Jij wel.

Op Reddit en in professionele netwerken klinkt vaak hetzelfde geluid:

“It’s fast and creative, but I wouldn’t trust it without double-checking it myself.”

Zelfs de meest geavanceerde AI heeft beperkingen als het gaat om interpretatie van meetwaarden, validatie van resultaten of naleving van veiligheidseisen. Dit wordt ook bevestigd in de ICT&Health-artikelen en door specialisten die AI inzetten als communicatietool, maar niet als beslisser.

Kortom: AI is geen vervanging van menselijke expertise en moet altijd onder toezicht worden gebruikt.

Voor welke labtaken is AI wél geschikt?

AI is uitermate geschikt voor ondersteunende labtaken zoals rapportages, literatuuranalyse, uitleg van protocollen en dataordening. Het versnelt processen, zonder in te grijpen op veiligheid of validatie.

In het lab zijn veel taken repetitief, tekstueel of data-intensief. Precies daar kan AI uitkomst bieden. Denk aan:

- Schrijven van rapport structuren: opstellen van inleiding, methode, resultaat en conclusie

- Uitleggen van moeilijke terminologie: AI vertaalt jargon naar begrijpelijke taal

- Samenvatten van wetenschappelijke artikelen: snel de essentie uit een paper halen

- Vertalen van protocollen of veiligheidsinstructies

- Opzoeken van normen en referentie-intervallen (mits geverifieerd)

- Genereren van checklisten, bulletpoints of evaluatievragen

Bijvoorbeeld: stel je moet een verslag maken over een pH-bepaling. Je geeft ChatGPT de data en vraagt om een overzichtelijke conclusie inclusief referentiewaarden. Binnen seconden heb je een eerste versie. Daarna check jij of alles klopt volgens jouw SOP.

Ook voor opleidingsdoeleinden wordt AI al breed ingezet. Studenten gebruiken het om practica voor te bereiden, scripties te structureren of examenvragen te oefenen.

De essentie is: AI blinkt uit in snelheid en taal, niet in interpretatie of verantwoordelijkheid. Door die grens goed te bewaken, kun je het slim inzetten zonder risico.

Hoe zit het met privacy en dataveiligheid?

Het invoeren van labgegevens in ChatGPT is risicovol zonder duidelijke dataveiligheidsmaatregelen. AI-tools verzamelen input, en dat roept grote vragen op over vertrouwelijkheid in laboratoria.

Eén van de grootste zorgen rondom het gebruik van AI in het lab is privacy. In veel laboratoriumomgevingen wordt gewerkt met gevoelige informatie: patiëntgegevens, onderzoeksresultaten, klinische metingen of zelfs vertrouwelijke projectdata. Deze data mag volgens de AVG (GDPR) niet zomaar gedeeld worden – en zeker niet met een AI-systeem dat draait op servers buiten jouw controle.

ChatGPT van OpenAI is een cloudgebaseerde tool. Hoewel je sessies privé lijken, kan de data theoretisch worden gebruikt voor trainingsdoeleinden – tenzij je via instellingen expliciet uitschakelt dat jouw input wordt opgeslagen. In bedrijfsomgevingen is dit vaak niet voldoende.

Daarom zeggen experts: voer nooit persoonsgegevens, patiëntinformatie of interne labdata in een openbare AI-tool in. Ook al gebruik je de tool alleen voor structuur of schrijfstijl, de context van je prompt kan gevoelige data bevatten.

Bedrijven die AI willen integreren in hun workflow doen er goed aan om te kijken naar ‘on-premise’ AI-tools of privacy-compliant oplossingen zoals:

- Zelfgehoste GPT-modellen

- Microsoft Azure OpenAI (met Europese datacenters)

- Specifieke AI-tools met medische CE-keurmerken

Daarnaast wordt in de Europese AI-verordening nadrukkelijk gesteld dat organisaties verantwoordelijk zijn voor de AI-systemen die zij gebruiken. Ook moeten medewerkers getraind worden in AI-geletterdheid, waaronder het herkennen van privacyrisico’s.

🔒 Meer weten over het belang van dataveiligheid en ISO-normen, ook bij thuisgebruik van labtesten? Lees dan ons blog over kwaliteitsborging in het thuislab – ISO, zelftesten & risico’s.

Praktische tips voor veilig AI-gebruik in het lab:

- Verwijder of vervang gevoelige data uit prompts (anonimiseren)

- Gebruik AI alleen op niet-privacygevoelige onderdelen (zoals structuur, taal of uitleg)

- Check of je organisatie een AI-policy heeft en volg die strikt

- Zet dataopslag uit in ChatGPT-instellingen of gebruik enterprise-oplossingen

Onze eigen poll laat zien dat veel professionals AI bewust vermijden bij gevoelige taken – juist vanwege deze risico’s. En terecht: een datalek of onbedoelde openbaarmaking van medische informatie kan enorme gevolgen hebben voor patiënten én organisatie.

Concluderend: veilig AI-gebruik in het lab begint bij bewustwording, beleid en de juiste tools.

Conclusie: AI als hulpmiddel, geen vervanging

ChatGPT en vergelijkbare AI-tools bieden krachtige ondersteuning in het lab ,maar ze vervangen geen ervaring, protocollen of menselijke interpretatie. Onze peiling bevestigt dat AI-gebruik groeit, maar altijd met de menselijke hand aan het stuur.

AI is snel, creatief en inzetbaar voor taken zoals:

- Rapport structuren opzetten

- Moeilijke termen uitleggen

- Literatuur samenvatten

- Suggesties doen voor lab communicatie

Maar AI kent ook beperkingen:

- Geen medische of procedurele context

- Geen toegang tot interne SOP’s of ISO-richtlijnen

- Kans op onjuiste of verzonnen informatie

Daarom blijft bewust gebruik essentieel. Werk met heldere AI-policies, train teams in AI-geletterdheid en gebruik AI alleen op plekken waar fouten geen directe risico’s vormen.

🔗 Wil je meer weten over dataveiligheid en kwaliteitsborging in het lab? Lees dan ook ons blog over ISO, thuislab en AI-risico’s.

Morgan Lab gelooft in een toekomst waarin mens én machine samenwerken, maar altijd met de juiste controle, expertise en ethiek.

Veelgestelde Vragen (FAQ)

1. Kan ChatGPT laboratoriumdata analyseren zoals een laborant dat doet?

Nee, ChatGPT kan geen laboratoriumdata analyseren zoals een menselijke laborant. Het mist medische context, instrumentkennis en inzicht in patiënt- of monstervariabelen.

ChatGPT kan wel uitleg geven over labwaarden in algemene zin, maar leest geen ruwe meetdata, herkent geen afwijkende patronen en mag nooit worden gebruikt voor interpretatie of klinische besluitvorming. Benieuwd naar meer hierover? Bekijk dan het volgende blog voor meer informatie over de rol van een laborant tijdens het ai-tijdperk.

2. Wat zijn de risico’s van het gebruik van AI in het lab?

De grootste risico’s zijn hallucinaties, verkeerde interpretatie van data en datalekken. ChatGPT kan foutieve info overtuigend formuleren, is niet gebonden aan validatieregels en heeft geen toegang tot SOP’s of actuele labsoftware. Daarnaast is het niet AVG-proof tenzij je specifieke maatregelen treft. Bij gevoelige data moet je AI-gebruik dus altijd beperken of goed beveiligen.

3. Voor welke lab taken wordt ChatGPT wél gebruikt?

ChatGPT wordt in het lab wel gebruikt voor rapportages, tekstuitleg, samenvattingen en vertalingen. Het vervangt geen laboratoriumhandelingen. Denk aan het herschrijven van een verslag, het vereenvoudigen van vakjargon of het samenvatten van literatuur. Meetwaarden, interpretaties en vrijgave blijven mensenwerk.

Veel labprofessionals gebruiken het om een verslag te structureren, een wetenschappelijk artikel samen te vatten of moeilijke begrippen begrijpelijker te maken. Ook wordt het ingezet om protocollen om te zetten in makkelijkere taal, maar nooit om meetwaarden te valideren of SOP’s te vervangen.

4. Wat zegt de Europese regelgeving over AI-gebruik op de werkvloer?

De AI-verordening stelt dat organisaties die AI gebruiken verplicht zijn om werknemers AI-geletterd te maken en zorgvuldig om te gaan met privacy en transparantie. Dit betekent dat laborganisaties een duidelijke AI-policy moeten hebben én hun medewerkers moeten trainen in veilig en verantwoordelijk gebruik.

5. Hoe kan ik als labprofessional veilig starten met AI?

Begin met niet-gevoelige taken zoals tekststructuur of hulp bij literatuurstudie. Vermijd patiëntgegevens en meetwaarden in prompts. Gebruik bij voorkeur AI in een afgeschermde of enterprise-omgeving (zoals Azure of zelfgehoste modellen). En bespreek met je team hoe AI binnen SOP’s en validatieregels past.

6. Kan ChatGPT laboratoriumresultaten lezen?

Nee, ChatGPT kan geen laboratoriumresultaten “lezen” of beoordelen zoals een labprofessional. Het kan alleen tekst interpreteren die jij invoert.

Het ziet geen trends, controleert geen validatieregels en heeft geen toegang tot LIS-systemen of analyzers. Eventuele uitleg is altijd generiek en contextloos.

7. Wat is het risico van ChatGPT specifiek voor labprofessionals?

Het risico zit vooral in overschatting van de output. ChatGPT klinkt zeker, maar kan inhoudelijk onjuist zijn en zelfs ernstige fouten maken.

Als labprofessional blijft jij eindverantwoordelijk. Blind vertrouwen op AI kan botsen met ISO-normen, validatie-eisen en professionele aansprakelijkheid.